简述对抗样本

对抗样本(Adversarial Examples)是AI领域中的一个重要概念,尤其是在深度学习和神经网络的研究中。它们指的是经过精心设计或修改的输入数据,这些数据在人类看来与原始数据几乎没有区别,但却能够欺骗AI模型,导致模型做出错误的预测或分类。

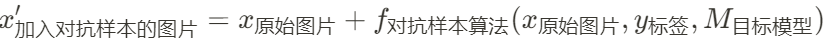

简单用个公式表达领域开山作FGSM派的思路:

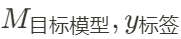

值得一提的是,

输入在某些对抗样本生成中不是必须的,特别是迁移对抗攻击。读者如果还想往前追溯对抗样本的思路,可以读读 Szegedy 等人的Intriguing properties of neural networks。实际上,个人感觉去年媒体热捧的保护个人画作风格不被大模型盗学的Glaze方法和 Szegedy 等人的方法有异曲同工之妙,我们会在最后详细讨论这部分。

特点

对抗样本有许多有意思的特性,受篇幅限制(即标题里的”精简版“三字😅)只列举以下两种,为下文埋个伏笔:

- Hardly Perceptible:对抗样本通常通过对原始输入数据加入微小但有效的扰动来生成,这些扰动足够小以至于人类观察者难以察觉,但足以迷惑目标模型。

- Transferability:对抗样本通常表现出迁移性,最开始这一特性是在FGSM对抗攻击实验上发现的,这意味着为攻击A模型而创建的对抗样本有时可以欺骗另一个模型B,即使两个模型具有不同的架构或在不同的数据集上训练。

应用和影响

能发paper的应用与影响就是好应用和影响(bushi🤫)

- 安全领域:在安全敏感的应用中,如面部识别、自动驾驶车辆和欺诈检测等,对抗样本可以被用来测试系统的鲁棒性。

- 模型改进:研究对抗样本不仅有助于理解深度学习模型的脆弱性,还可以通过对抗训练(在训练过程中引入对抗样本)来增强模型的鲁棒性和泛化能力。

大模型(LLM)下的对抗样本

Recent text-to-image diffusion models such as MidJourney and Stable Diffusion threaten to displace many in the professional artist community. In particular, models can learn to mimic the artistic style of specific artists after “fine-tuning” on samples of their art.

作为一位生活在当代的艺术家,除了传统的开办画展,通过在社交媒体上传自己的作品获得外界关注应该是更普遍的方式。但随着以CLIP为代表的大模型的研究落地,越来越多的艺术创作者的成果未经授权就被盗用成为大模型的训练数据,进行大模型微调而生成与艺术创作者风格相同的作品。

首先简单剖析一下参与方:

画家🧑🏼🎨:我需要社交媒体上传我们的作品获取外界对自己的关注。

炼丹人🕵🏼♂️:爬那些画家上传的作品丢给大模型微调训练,我就可以不断生成类似风格的作品用于自身盈利或**(NSFW🤫)。

社交媒体平台👨🏼💼:炼丹人浏览选择下载艺术家作品的的流量也能为网站带来盈利,且为艺术家维权费时费力好处少。

由此不难看出,最有效的维权方式,还得是艺术家给自己上传的作品做手脚,包括但不限于给作品加大水印,如下图:

此时此刻回收伏笔:Hardly Perceptible and Transferability 对抗攻击的不可察觉性给作品加入微小但有效的扰动,并且这些扰动足够小以至于人类观察者难以察觉;对抗攻击的迁移性使得作品扰动能抵抗各类大模型的微调学习。

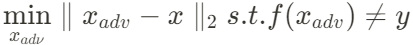

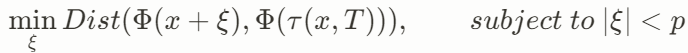

写在最后,感兴趣的读者可以比较Intriguing properties of neural networks和Glaze的方法目标公式:

Intriguing properties of neural networks:

相信能更好理解文章。